合作机构:阿里云 / 腾讯云 / 亚马逊云 / DreamHost / NameSilo / INWX / GODADDY / 百度统计

资讯热度排行榜

- 91131大模型×文本水印:清华、港

- 90372一文读懂如何基于 GenA

- 902532024 年,3 项技术将

- 89864利用人工智能增强网络安全防

- 89685GPT-4准确率最高飙升6

- 89676AI在工业物联网(IIoT

- 89627人工智能和机器学习在物联网

- 89598一句话让小姐姐为我换了N套

- 893492024年人工智能与数字孪

- 891810AI时代来了,专业摄影师会

推荐阅读

- 01-241技术趋势:2024年的热点是什么

- 01-252网络安全在自动驾驶汽车中的作用

- 01-253OpenAI创始人想打造全球芯片

- 01-264强化学习和世界模型中的因果推断

- 01-265Mamba论文为什么没被ICLR

- 01-296让知识图谱成为大模型的伴侣

- 01-297从20亿数据中学习物理世界,基于

- 01-298谷歌云与Hugging Face

- 01-299人工智能和机器学习在物联网中的作

- 01-2910无需人工标注!LLM加持文本嵌入

中文性能反超VLM顶流GPT-4V,阿里Qwen-VL超大杯限免!看图秒写编程视觉难题一眼辨出

最近,通义千问实火。

前段时间被网友玩疯的全民舞王,让「AI科目三」频频登上热搜。

让甄嬛、慈禧、马斯克、猫主子和兵马俑能跳舞那款AI,就藏在通义千问APP背后。

来源:深夜来点薯片

来源:深夜来点薯片

最强国产视觉语言模型了解一下

就在这几天,通义千问团队又对多模态大模型下手了——

再一次升级通义千问视觉语言模型Qwen-VL,继Plus版本之后,又推出Max版本。

Qwen-VL是阿里在2023年8月推出的具备图文理解能力的大模型,基于通义千问语言模型开发。升级后的Qwen-VL视觉水平大幅提升,对很多图片的理解水平接近人类。

并且,还能够支持百万像素以上的高清分辨率图,以及各种极端长宽比的图片。

升级版模型限时免费,在通义千问官网和APP都可体验,API也可免费调用。

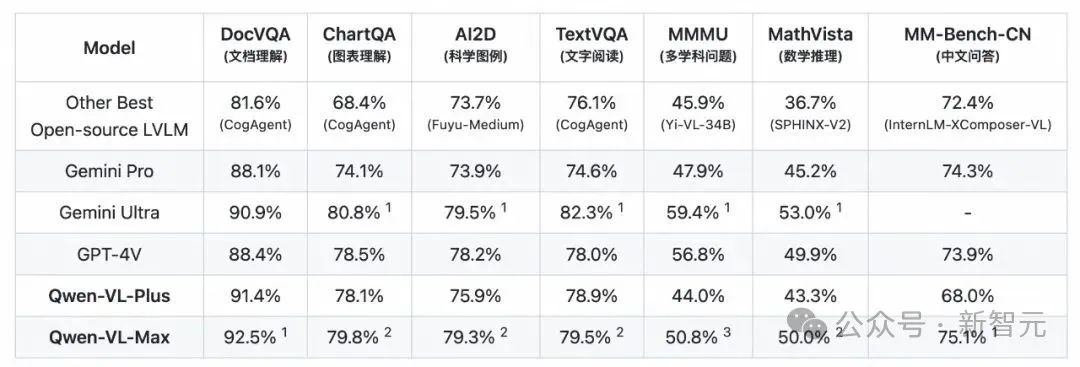

评测结果显示,Qwen-VL的升级版本在MMMU、MathVista等任务上远超业界所有开源模型,在文档分析(DocVQA)、中文图像相关(MM-Bench-CN)等任务上超越GPT-4V,达到世界最佳水平。

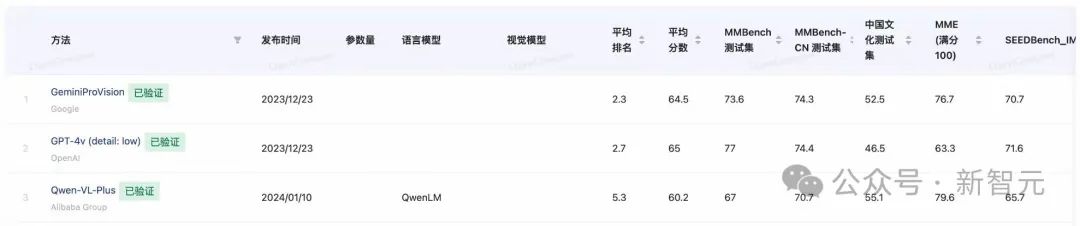

在第三方权威评测上,Qwen-VL常常与GPT-4V、Gemini携手占据业界三强,与其他竞争者拉开相当大的差距。

来源:OpenCompass

话不多说,小编立马展开实测。

多模态基础能力

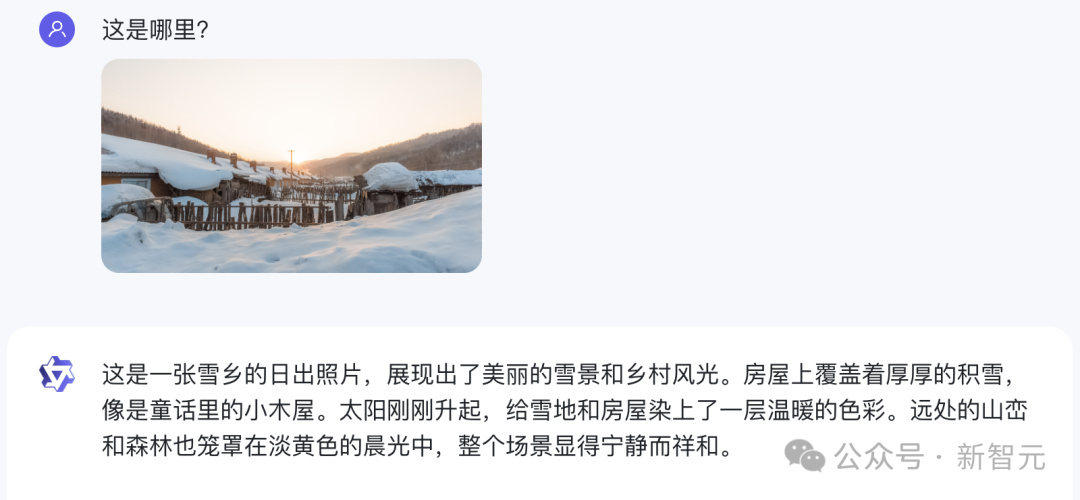

首先,我们直接来了一道难度拉满的题——一张小编十年前在雪乡拍的照片。

Qwen-VL-Max不仅一眼认了出来,而且还配上了一段非常优美的描写:

房屋上覆盖着厚厚的积雪,像是童话里的小木屋。太阳刚刚升起,给雪地和房屋染上了一层温暖的色彩。远处的山峦和森林也笼罩在淡黄色的晨光中,整个场景显得宁静而祥和。

而GPT-4V则表示,由于没有具体的地标,因此无法给出确切的位置。

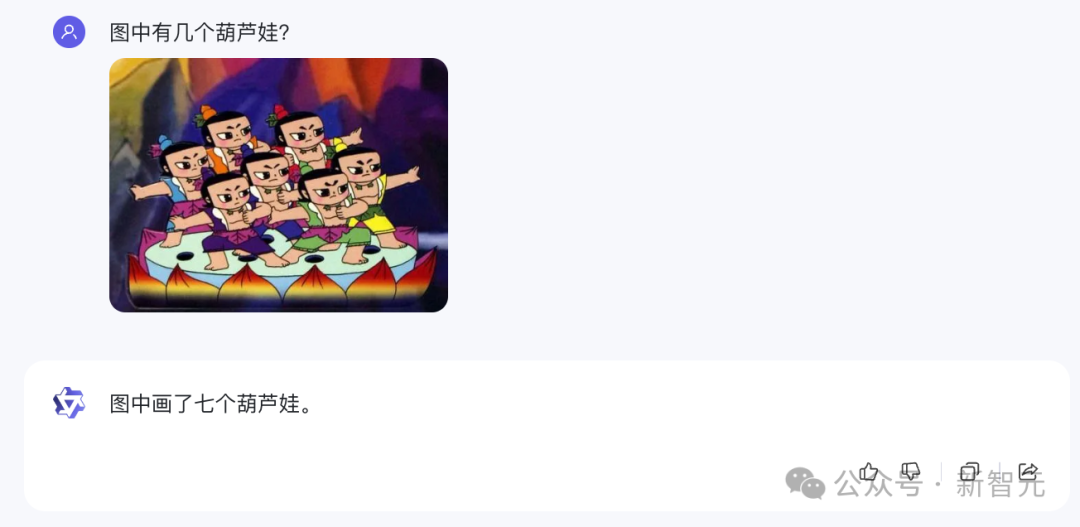

接下来,Qwen-VL-Max不仅数对了难倒GPT-4V的「数数几个葫芦娃」问题。

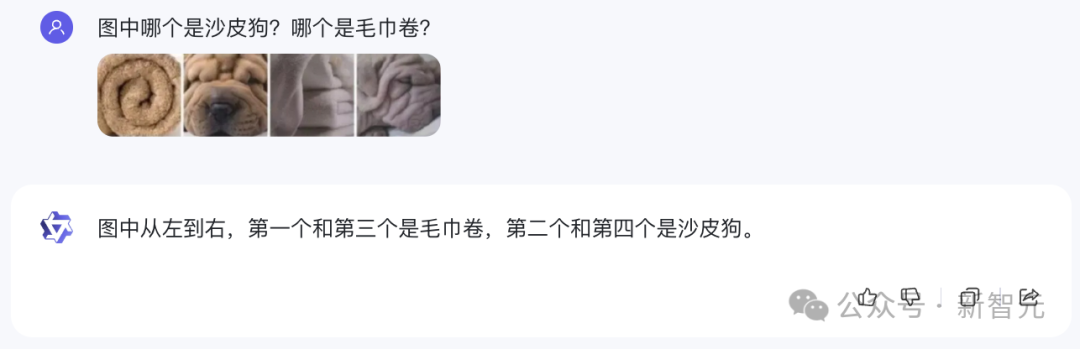

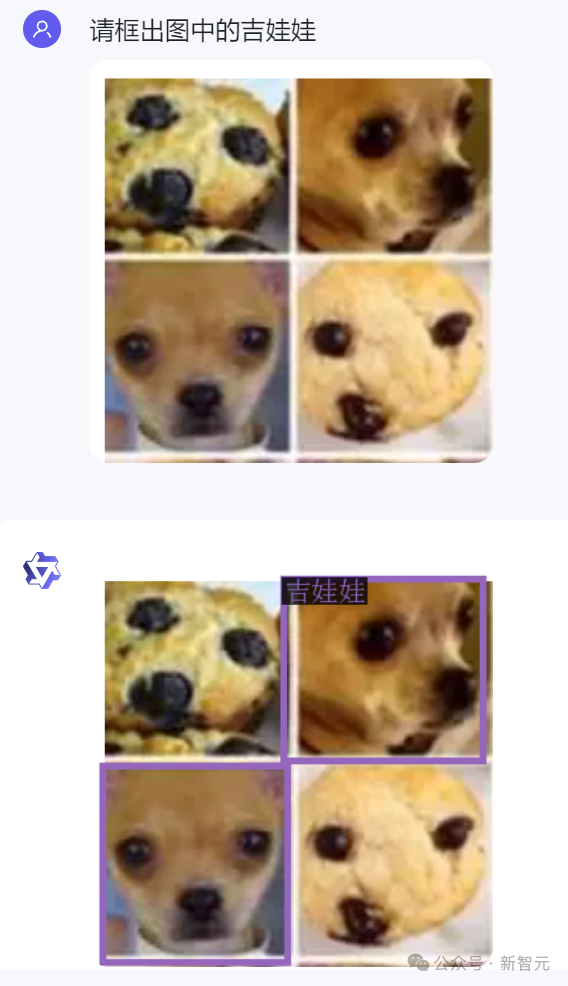

而且还通关了经典的计算机视觉难题——「吉娃娃与松饼」。

类似的「毛巾卷和沙皮狗」、「柯基屁股与土司」等等,也能顺利答出。

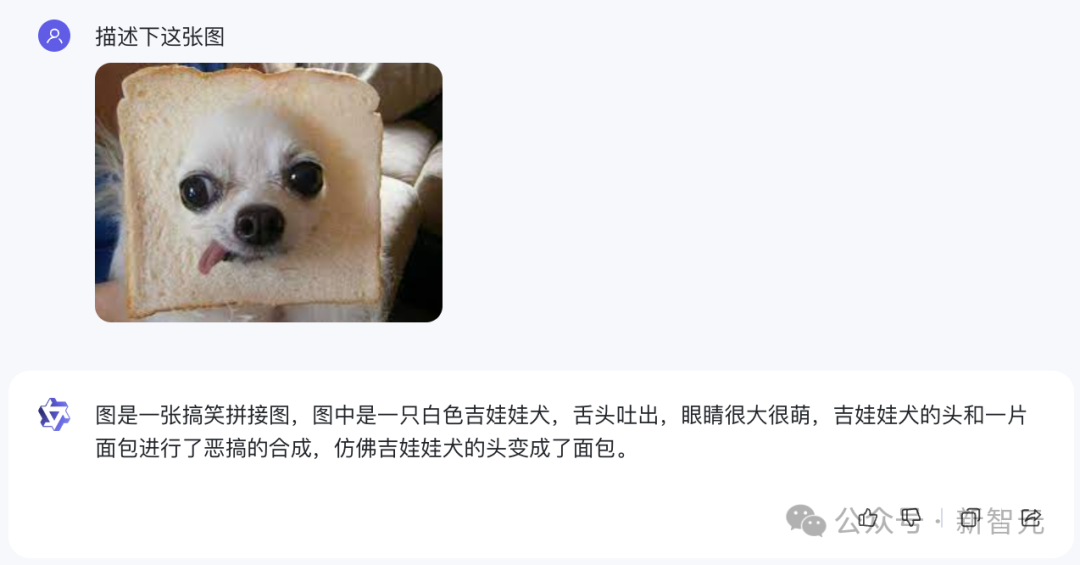

甚至它还可以理解「给吉娃娃套上吐司」这样恶搞的图片。

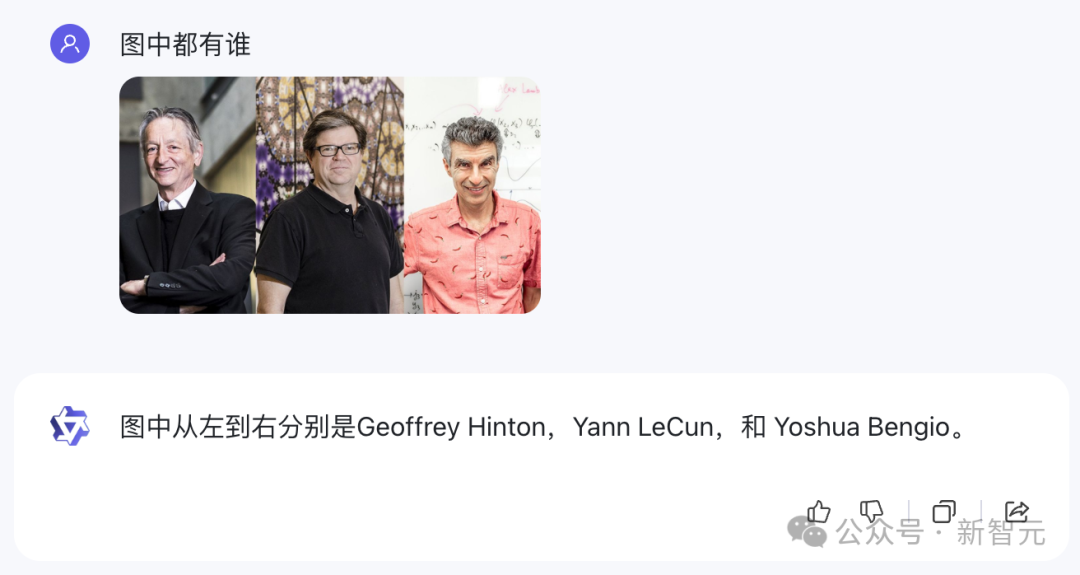

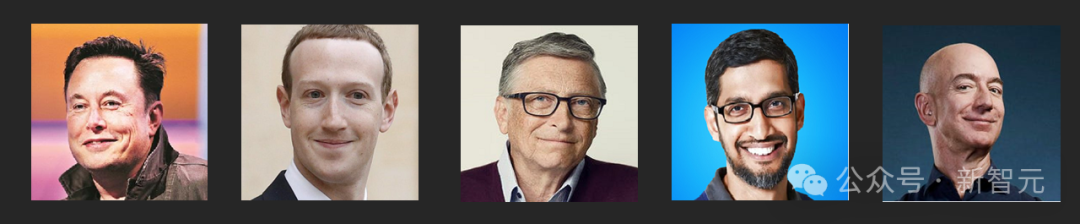

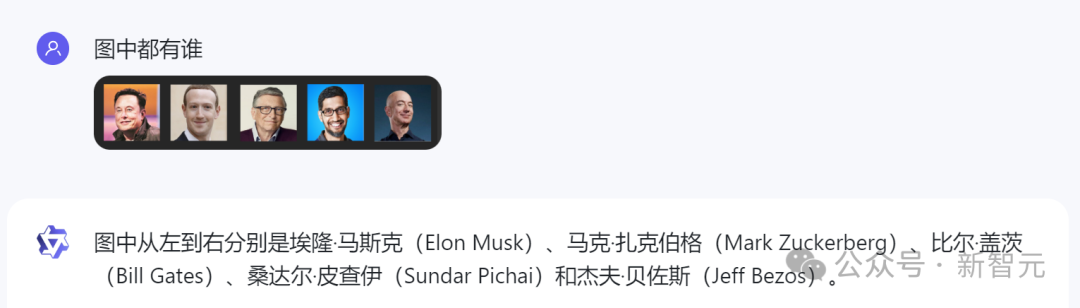

对于在一张图里分别辨认多个名人这类问题,Qwen-VL-Max同样能够立刻给出正确的回答。

比如刚刚当选ACM Fellow的图灵三巨头。

以及科技圈的一众大佬。

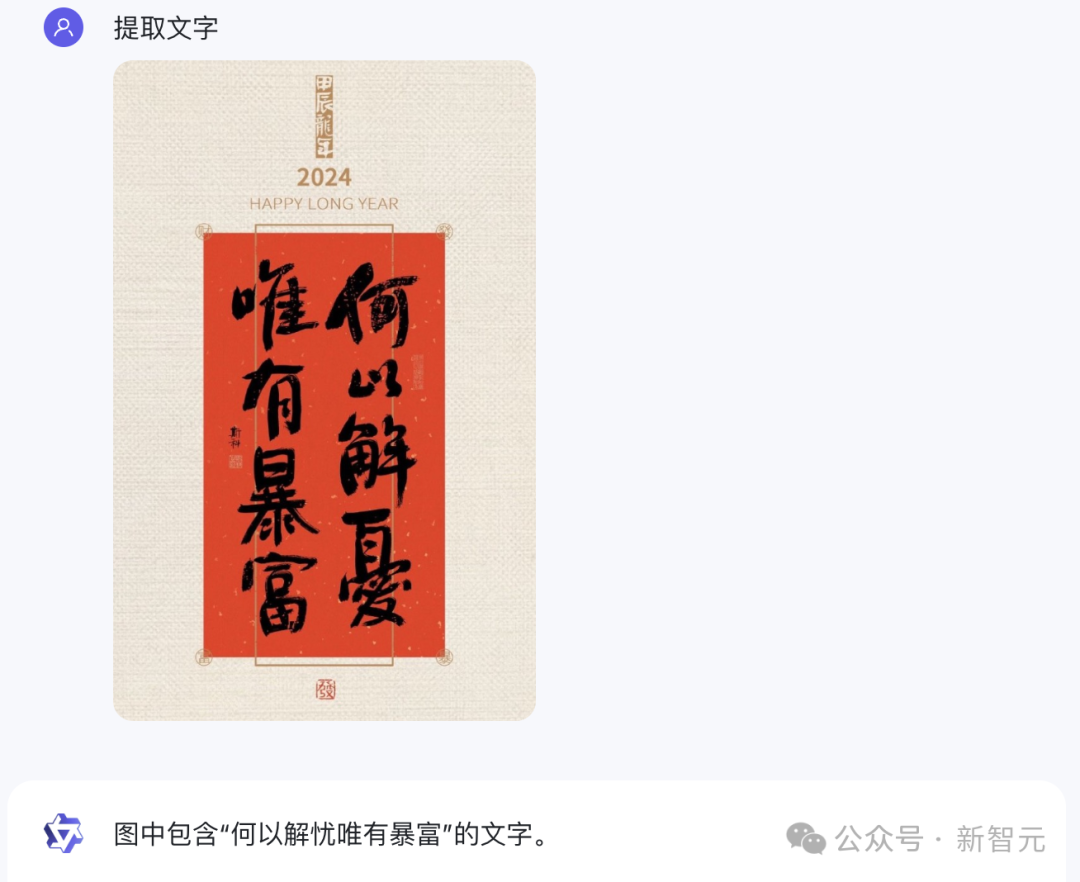

同样,它也可以精准识别出图像中的文字,即便是手写体也不在话下。

相比之下,GPT-4V却未能识别对图中毛笔写的字,而是给出了「恭贺新禧大吉大利」。

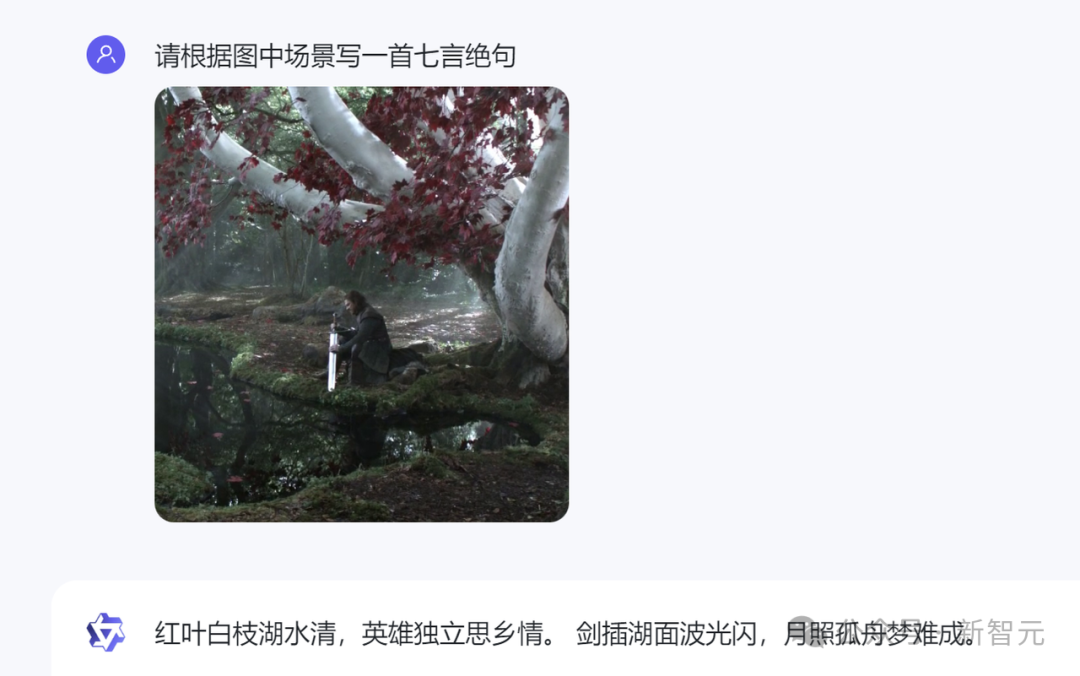

有趣的是,Qwen-VL-Max还能根据自己对图像的理解写诗。

比如这首根据「权力的游戏」中的名场面作的中文诗,就颇有意境。

而根据同一个场景作出的英文诗,也很有韵致。

视觉Agent能力

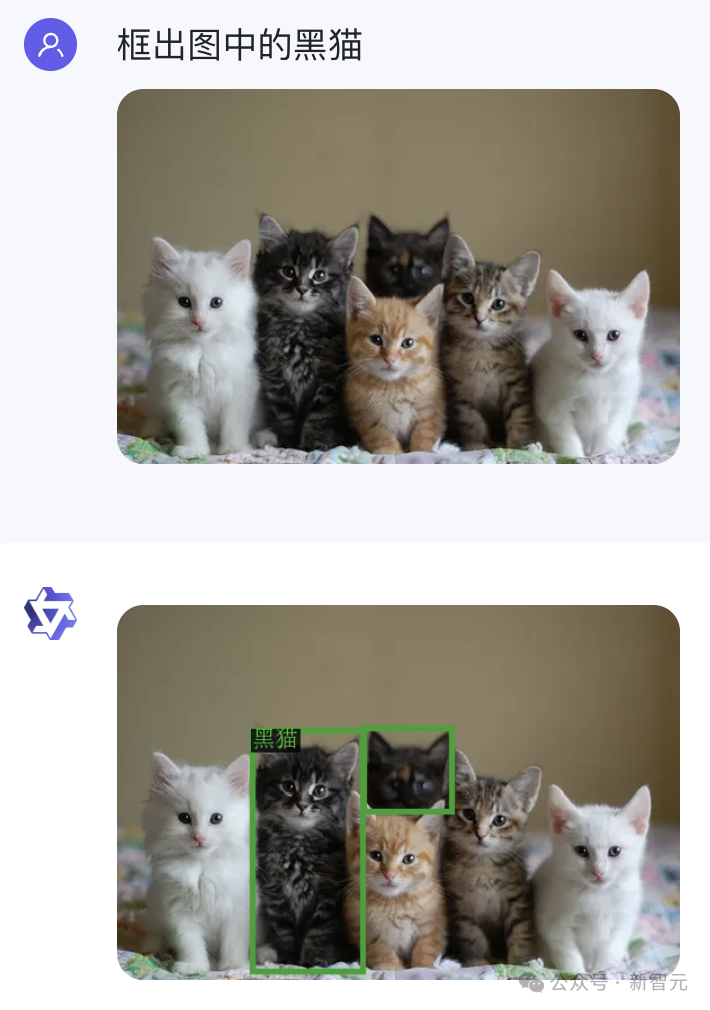

除了基础的描述和识别能力外,Qwen-VL-Max还具备视觉定位能力,可以针对画面指定区域进行问答。

比如它能在一群猫猫中准确框出黑猫。

还能在吉娃娃和松饼中框出吉娃娃。

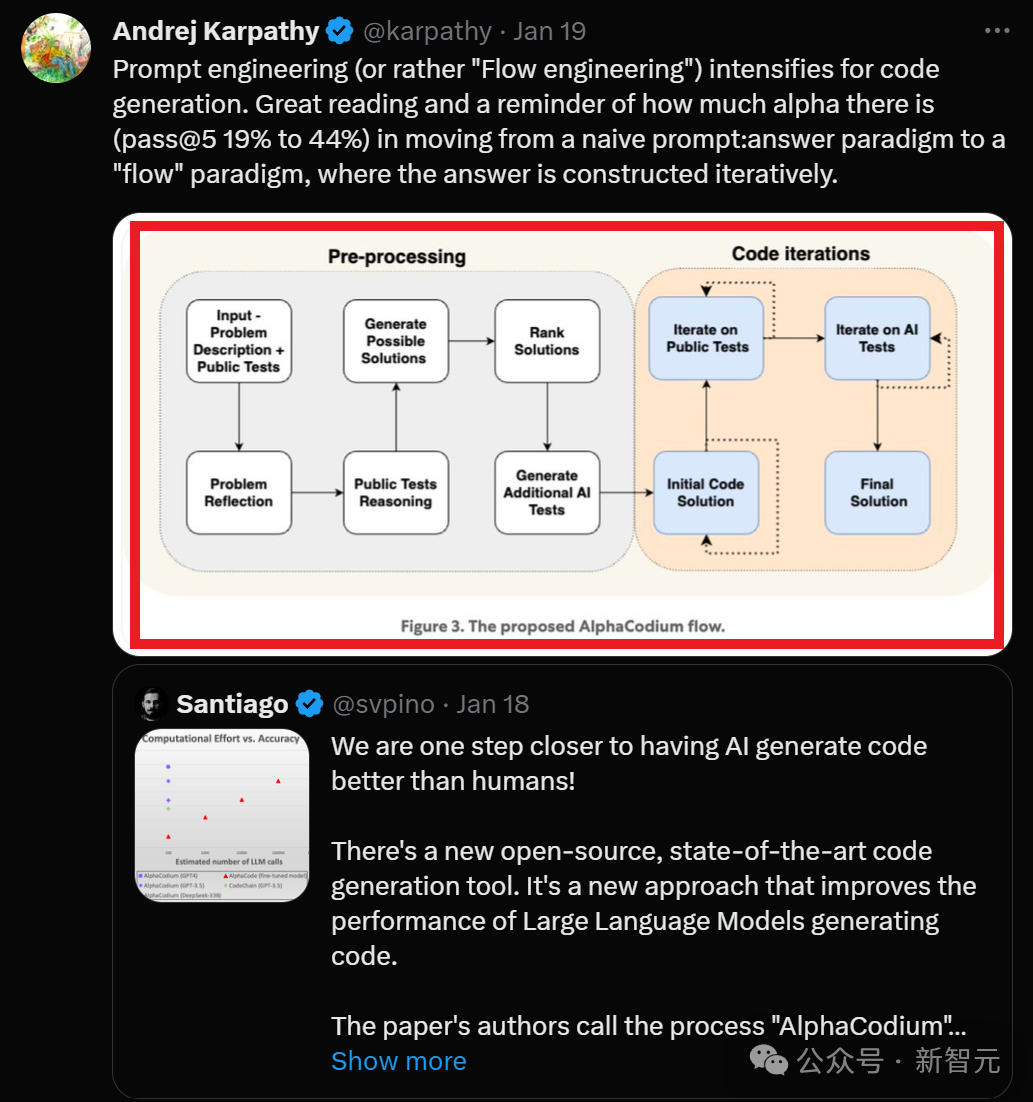

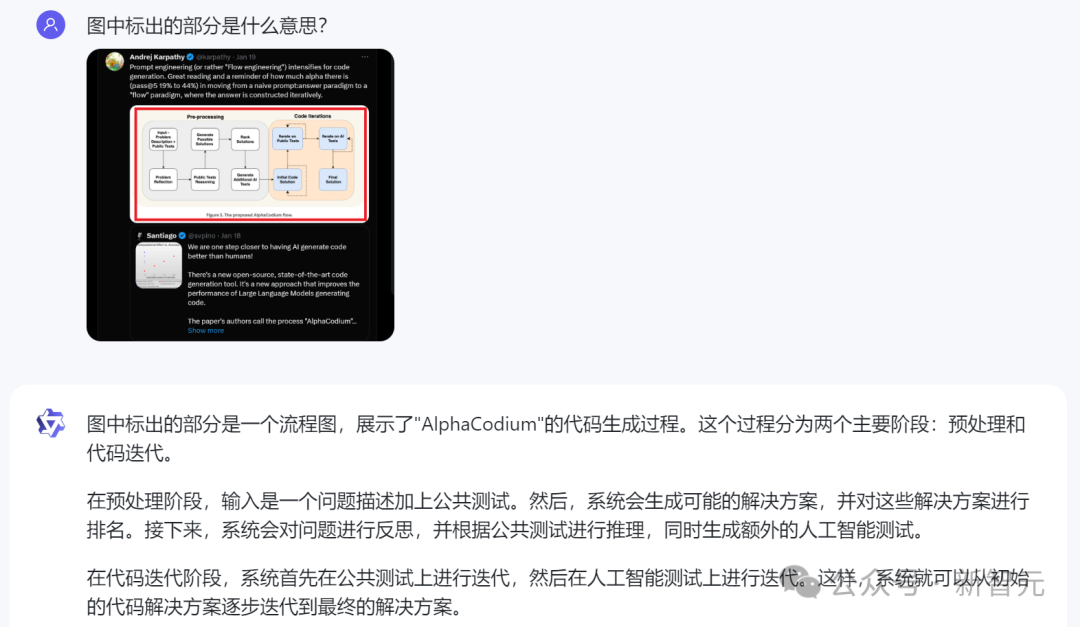

我们标出OpenAI联创Karpathy帖子中的一个图,问Qwen-VL-Max标出的部分是什么意思。

它立马给出的正确回答:标出的部分是流程图,展现了AlphaCodium的代码生成过程。同时还给出了正确的描述。

关键信息提取处理

在实测中我们发现,Qwen-VL-Max最显著的进步之一,就是基于视觉完成复杂的推理。

这不仅限于描述内容,而是能理解复杂的表达形式。

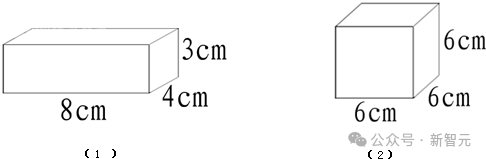

比如,下面这道看似简单初中几何题,由于条件信息都被嵌入进了图像里的,其实难倒了不少视觉模型:

相比之下,Qwen-VL-Max直接给出了正确解答。

上下滑动查看

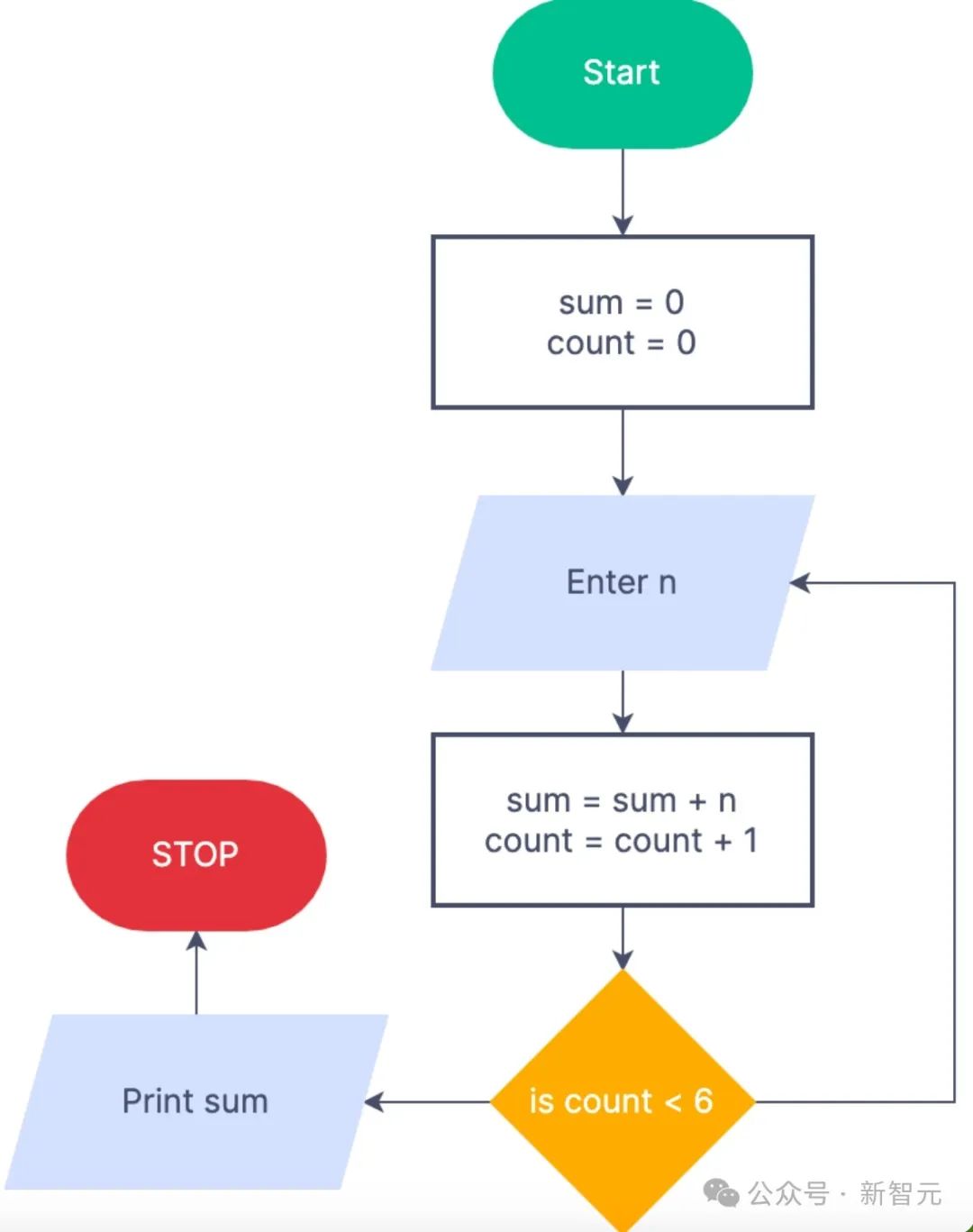

再比如解释下图中的算法流程图。

Qwen-VL-Max会清晰地给出整套流程的解释,包括每一步之后需要进行的步骤。

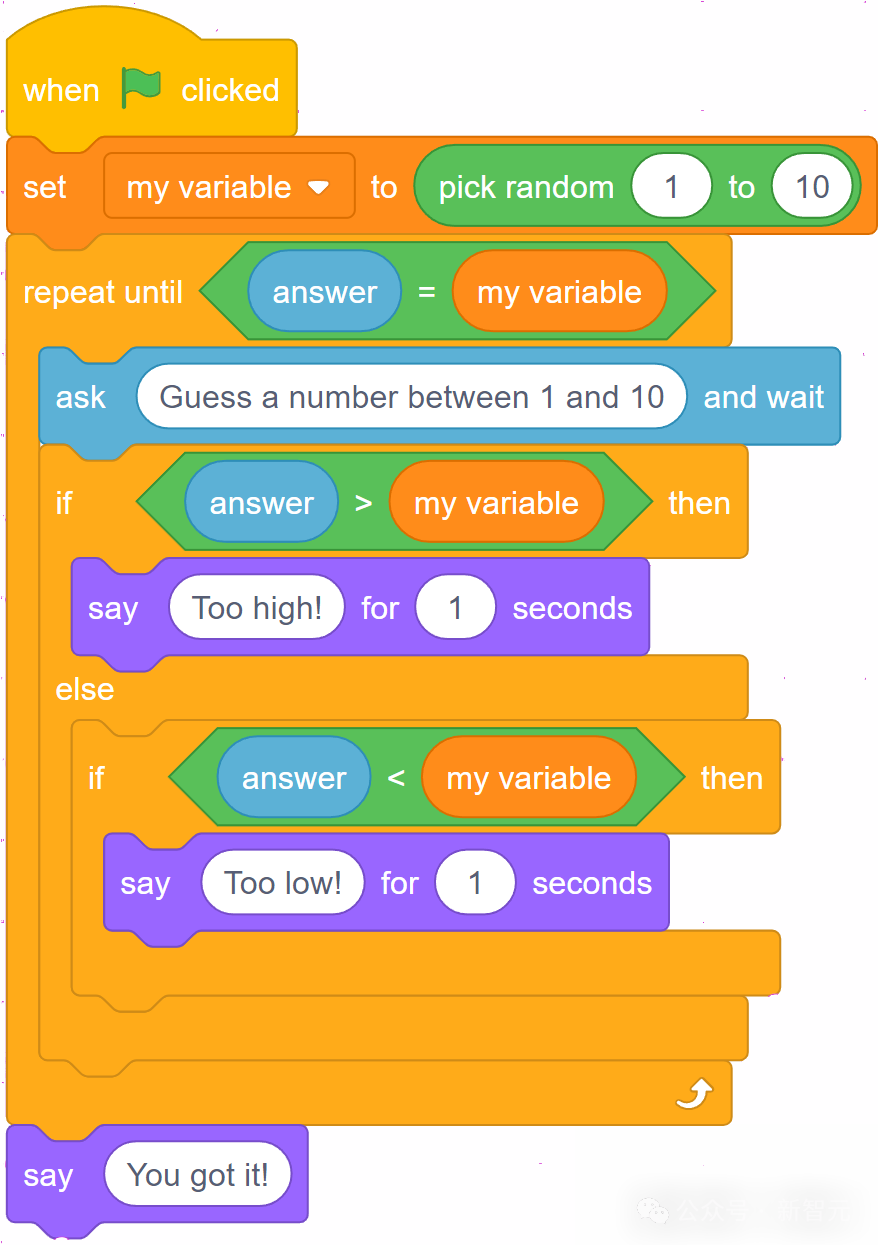

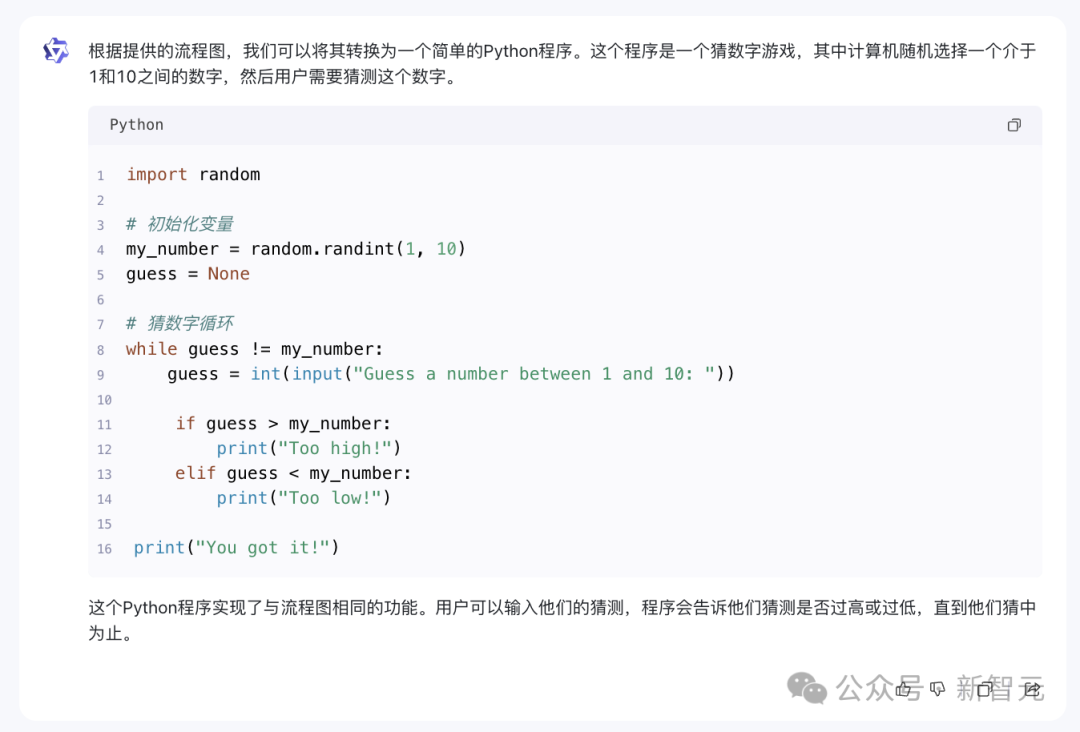

小朋友的编程题,它也能正确地理解图中的流程,转换成Python程序。

import random

# 初始化变量

my_number = random.randint(1, 10)

guess = None

# 猜数字循环

while guess != my_number:

guess = int(input("Guess a number between 1 and 10: "))

if guess > my_number:

print("Too high!")

elif guess < my_number:

print("Too low!")

print("You got it!")-

TOP